위르겐 슈미트후버

위르겐 슈미트후버(Jürgen Schmidhuber, 1963년 1월 17일 ~ )는 인공신경망 분야에서 인공지능(AI) 연구로 잘 알려진 독일의 컴퓨터과학자이다. 그는 스위스의 달레몰 인공지능 연구소(IDSIA)의 소장이다. 또한 사우디아라비아의 왕립압둘라과학기술대학교(KAUST) 컴퓨터·전기·수학과학 및 공학(CEMSE) 학부에서 인공지능 이니셔티브 책임자이자 컴퓨터과학 교수로 재직 중이다. 독일 뮌헨 출신의 학자로서, 오랫동안 실용적 사용에 어려움이 있던 순환인공신경망(RNN)의 난제를 제자인 셰이퍼 호흐라이터(Sepp Hochreiter)와 해결했다. 딥러닝의 아버지라는 별명이 있다.

그는 장단기 기억(LSTM, Long Short-Term Memory) 신경망 구조에 대한 기초 연구로 가장 잘 알려져 있으며, 이 기술은 2010년대 연구 및 상업적 응용에서 자연어 처리(NLP) 분야의 핵심 기술로 자리 잡았다. 또한 동적 신경망, 메타 러닝, 생성적 적대 신경망(GAN), 선형 트랜스포머 등의 개념을 도입했으며, 이는 현대 AI 연구에서 광범위하게 활용되고 있다.

목차

[숨기기]생애[편집]

위슈미트후버는 고등학교를 졸업 후, 컴퓨터과학과 수학을 공부했다. 대학에서는 컴퓨터과학 박사 학위를 취득하고, 인공지능이나 인공신경망(neural network)에 관한 논문을 발표했다. 여기서 인공신경망은 하드와 소프트의 편성에 의해 뇌내의 뉴런끼리의 연결 구조를 모방한 것이다. 위르겐 슈미트후버가 루가노에서 생활하게 된 지 23년이 지났을 때 계기를 만든 것은 이탈리아인 술 수입업자 안젤로 달레몰레이다. 치날이라는 아티초크를 원료로 한 식전주를 개발해 부자가 된 달레몰레는 지적인 기계를 노동력으로 사용하는 유토피아 건설을 꿈꾸고 있었다. 그의 거액 기부를 바탕으로 1988년에 루가노에 달레몰 인공지능 연구소가 설립되었다. 설립 이후, 위르겐 슈미트후버는 이른 시기부터 인공지능 연구소에서 일했다. 인공지능 연구소는 현지의 대학과의 제휴나 정부로부터의 보조금으로 루가노를 인공지능 연구의 중심지로 바꾸어 놓았다. 위르겐 슈미트후버는 루가노 중심부에 있는 스위스 이탈리아 대학에서 강의하고 있으며, 외진 교외에 있는 스위스 달르몰 인공지능연구소(IDSIA)의 연구시설에서도 일하고 있다. 2014년에는 4명의 전 제자들과 함께 네이선스를 설립했다. 제조, 의료, 금융 분야의 상업적 파트너십과 순수 연구 연계를 위해 장소는 대학 근처로 잡았다.[1]

15살 때부터 위르겐 슈미트후버의 목표는 자신보다 더 똑똑하고 자기개선을 하는 인공지능을 구축한 후 은퇴하는 것이었다. 그의 연구실에서 나온 장단기 메모리(LSTM)는 기계학습에 혁명을 가져왔다. 장단기 메모리는 오늘날의 30억개의 스마트폰에 탑재되어 다양한 어플리케이션을 통해 하루에 수십억번 이용되고 있다. 또한, 그는 교사 없는 학습, 인공호기심(artificial curiosity), 메타러닝 머신의 선구자이기도 하다. 수많은 상을 수상했으며, 최초의 실용적인 범용 인공지능 구축을 목적으로 한 네이선스(NNAISENSE) 사의 주임 과학자이기도 하다. 인공지능 전략에 대해 다양한 정부에 대한 조언도 하고 있다.[2]

경력[편집]

슈미트후버는 독일 뮌헨 공과대학교에서 학부(1987년)와 박사(1991년) 과정을 마쳤으며, 그의 박사 지도 교수는 빌프리트 브라우어(Wilfried Brauer)와 클라우스 슐텐(Klaus Schulten)이었다. 그는 2004년부터 2009년까지 해당 대학에서 강의를 했으며, 2009년부터 2021년까지 스위스 루가노에 있는 스위스 이탈리아 대학(Università della Svizzera Italiana)에서 인공지능 교수로 재직했다.

그는 1995년부터 스위스 AI 연구소인 달레 몰 인공지능 연구소(IDSIA)의 디렉터로 활동하고 있다.

2014년에는 금융, 중공업, 자율주행 자동차 등 다양한 산업 분야에서 인공지능의 상업적 응용을 연구하기 위해 Nnaisense라는 회사를 설립했다. 세프 호크라이터(Sepp Hochreiter), 얀 탈린(Jaan Tallinn), 마르쿠스 후터(Marcus Hutter) 등이 이 회사의 고문을 맡고 있다. 2016년 기준 매출은 1,100만 달러 미만이었으나, 슈미트후버는 현재 연구에 초점을 맞추고 있으며, 수익보다는 연구 개발을 우선한다고 밝혔다. Nnaisense는 2017년 1월 첫 번째 자금 조달 라운드를 완료했으며, 궁극적으로 다양한 개별 작업을 순차적으로 학습하는 범용 AI 개발을 목표로 하고 있다.

연구[편집]

1980년대에는 역전파(backpropagation) 기법이 신경망에서 긴 신호 경로(credit assignment paths)를 처리하는 딥러닝에 효과적이지 않았다. 이를 해결하기 위해 슈미트후버는 1991년 계층적 순환 신경망(RNN) 구조를 제안했으며, 이를 자기지도 학습(self-supervised learning)으로 단계별로 사전 훈련하는 방법을 개발했다 이 접근법은 예측 코딩(predictive coding)을 활용하여 여러 시간적 규모에서 내부 표현을 학습하며, 딥러닝의 성능을 크게 향상시킬 수 있다. 이 RNN 계층 구조는 상위 수준의 청커(chunker) 네트워크를 하위 수준의 자동화(automatizer) 네트워크로 증류(distillation)하여 단일 RNN으로 통합할 수 있다. 1993년, 이 방법을 사용한 청커 네트워크는 1,000개 이상의 깊이를 가진 딥러닝 문제를 해결했다.

1991년, 슈미트후버는 서로 경쟁하는 적대적 신경망(adversarial neural networks) 개념을 발표했다. 이는 제로섬 게임(zero-sum game)의 형태로, 한 신경망의 이득이 다른 신경망의 손실이 되는 방식이다. 첫 번째 신경망은 출력 패턴의 확률 분포를 모델링하는 생성 모델이며, 두 번째 신경망은 환경의 반응을 예측하는 모델이다. 이 개념은 "인공 호기심(artificial curiosity)"이라고 불렸다. 이후 2014년, 이 원칙이 생성적 적대 신경망(GAN)에 적용되어 딥러닝 분야에서 중요한 기술로 자리 잡았다.

그는 1991년 세프 호크라이터의 졸업 논문을 지도했으며, 이 논문을 "기계 학습 역사상 가장 중요한 문서 중 하나"라고 평가했다. 이 논문은 신경 이력 압축기(neural history compressor)에 대한 연구를 다루었으며, 특히 사라지는 그래디언트 문제(vanishing gradient problem)를 분석하고 해결하는 방법을 제시했다. 이를 통해 LSTM이 탄생했으며, 1995년 기술 보고서에서 'LSTM'이라는 명칭이 처음 사용되었고, 1997년 호크라이터와 슈미트후버가 발표한 논문이 LSTM 연구에서 가장 많이 인용되었다.

2000년, 펠릭스 거스(Felix Gers), 슈미트후버, 프레드 커민스(Fred Cummins)는 오늘날 거의 모든 응용 프로그램에서 사용되는 표준 LSTM 구조를 제안했다. 이후, 2005년 그의 학생인 알렉스 그레이브스(Alex Graves)와 함께 시간 역전파(BPTT, Backpropagation Through Time)를 이용한 \바닐라 LSTM\이 발표되었으며, 2006년에는 LSTM을 이용한 연결주의적 시퀀스 학습(CTC, Connectionist Temporal Classification) 알고리즘이 소개되었다.

2010년대 들어, LSTM은 음성 인식, 기계 번역을 포함한 다양한 자연어 처리(NLP) 작업에서 주요 기법이 되었으며, 구글 뉴럴 머신 번역(Google Neural Machine Translation),[24] 구글 보이스 음성 인식, 시리(Siri) 등 여러 상용 기술에 적용되었다.

2014년 당시, 가장 깊은 신경망은 20~30개 층을 가진 모델이었다. 하지만 지나치게 많은 층을 쌓으면 학습 정확도가 급격히 감소하는 \성능 저하(degradation)\ 문제가 발생했다. 2015년 5월, 루페시 쿠마르 스리바스타바(Rupesh Kumar Srivastava), 클라우스 그레프(Klaus Greff), 슈미트후버는 LSTM 원리를 활용한 하이웨이 네트워크(highway network)를 개발했으며, 이는 수백 개 층을 가진 최초의 피드포워드 신경망이었다. 같은 해 12월, 하이웨이 네트워크의 변형인 레지듀얼 네트워크(ResNet)가 발표되었다.

1992년, 그는 순환 신경망(RNN)의 대안으로 빠른 가중치 프로그래머(fast weights programmer)를 제안했다. 이는 느린 피드포워드 신경망이 외적(outer product)을 통해 다른 신경망의 가중치를 빠르게 조절하는 방식이다. 이는 이후 선형 트랜스포머(linear transformer)와 유사한 방식으로 해석되었다. 슈미트후버는 1993년 "내부 주의 집중 학습(learning internal spotlights of attention)"이라는 용어를 사용했다.

2011년, IDSIA에서 슈미드후버와 그의 박사후 연구원 댄 치레산(Dan Ciresan)은 GPU 기반 병렬 연산을 통해 컨볼루션 신경망(CNN)의 학습 속도를 획기적으로 향상시켰다. 2006년 첼라필라(Chellapilla) 등이 개발한 GPU 기반 CNN은 CPU 대비 4배 빠른 성능을 보였으나, IDSIA의 딥 CNN(2011년)은 이미 60배 더 빠른 성능을 달성했고, 2011년 8월 컴퓨터 비전 대회에서 최초의 인간 초월(superhuman) 성능을 기록했다. 2011년 5월 15일부터 2012년 9월 10일까지, 이 CNN들은 4개의 이미지 대회에서 우승했으며, 여러 이미지 벤치마크에서 최첨단 성능을 달성했다. 이러한 접근 방식은 이후 컴퓨터 비전 분야의 핵심 기술이 되었다.

주요 활동[편집]

위르겐 슈미트후버는 그의 학생들인 펠릭스 거스(Felix Gers), 프레드 커민스(Fred Cummins), 알렉스 그레이브스(Alex Graves) 등과 함께 순환 신경망 유형의 더 정교한 버전인 장단기 메모리(LSTM)를 발표했다. 첫 번째, 결과는 호크라이터의 졸업장 논문에서 보고되었으며, 기울기 소실 문제(vanishing gradient problem)를 해결하여 분석했다. 장단기 메모리라는 이름은 기술 보고서에서 가장 많이 인용된 장단기 메모리 출판물에 소개되었다. 애플리케이션에서 사용되는 표준 장단기 메모리 구조는 2000년에 도입되었으며, 시간 경과에 따른 백프로파그(BBTT)를 이용한 '바닐라 장단기 메모리'는 2005년에 출판되었다. 2006년에는 연결주의 시간 분류(CTC) 훈련 알고리즘이 발표되었다. 연결주의 시간 분류는 장단기 메모리로 엔드투엔드(end-to-end) 음성 인식을 가능하게 했다. 연결주의 시간 분류가 교육한 장단기 메모리는 구글의 스마트폰용 소프트웨어 음성인식의 새로운 구현에 활용되었다. 구글은 스마트 어시스턴트 알로와 구글 번역에도 장단기 메모리를 사용하였다. 애플은 아이폰의 퀵타입 기능과 시리(Siri)에 장단기 메모리를 사용했다. 아마존은 장단기 메모리를 아마존 알렉사에 사용하였다. 또한, 페이스북은 장단기 메모리 네트워크를 이용해 매일 45억 개의 자동번역을 수행했다.

2011년, 달레몰 인공지능 연구소의 슈미트후퍼 팀은 그의 포스트닥인 댄 크리슨(Dan Ciresan)과 함께 그래픽처리장치(GPU)라고 불리는 고속 병렬 컴퓨터 상에서 콘볼루션 신경 네트워크(CNNs)의 속도를 극적으로 향상시켰다. 셸라피야(Chellapilla)등 그래픽 처리 장치에 대한 이전 콘볼루션 신경 네트워크는 중앙처리장치(CPU)에 대한 동등한 구현보다 4배 더 빨랐다. 2011년 5월 15일부터 2012년 9월 10일까지, 그들의 콘볼루션 신경 네트워크는 네 개의 이미지 대회에서 우승했다. 또한, 다중 이미지 데이터베이스에 대한 문헌에서 최상의 성능을 현저하게 향상시켰다. 그 접근법은 컴퓨터 비전 분야의 중심이 되었다. 이전의 얀(Yann LeCun) 외 연구진이 백프로파게이지 알고리즘을 쿠니히코 후쿠시마(Kunihiko Fukushima)의 원래 콘볼루션 신경 네트워크 구조인 네오코이그니트론(neocognitron) 변종에 적용했다가 나중에 주양웅(Juyang Weng)의 방법인 맥스 풀링(max-pooling)에 의해 변형된 콘볼루션 신경 네트워크 디자인을 바탕으로 하고 있다.

2014년 위르겐 슈미트후버는 나이스엔스라는 회사를 설립해 금융, 중공업, 자율주행차 등 분야에서 인공지능의 상업적 응용에 힘썼다. 2016년 매출액은 1,100만 달러 미만이었지만, 위르겐 슈미트후버는 강조점은 수익이 아니라 연구에 있다고 말했다. 나인센스는 2017년 1월 1차 자금조달 방식을 도입했으며, 유루겐 슈미트후퍼의 전반적인 목표는 다양한 좁은 과제에 대해 하나의 인공지능을 순차적으로 훈련시켜 다목적 인공지능을 만드는 것이다.[3]

장단기 메모리[편집]

1997년, 장단기 메모리는 셰이퍼 호흐라이터와 위르겐 슈미트후버에 의해 제안되었다. 컨티뉴어스 에러 카로젤(Continuous Error Carrozel) 유닛을 도입한 장단기 메모리는 기울기 소실 문제를 해결했다. 장단기 메모리 블록의 초기 버전은 셀, 입력 및 출력 게이트를 포함한다. 펠릭스 거스, 위르겐 슈미트후버, 프레드 커민스는 장단기 메모리구조에 망각 게이트를 도입하여 장단기 메모리이 자신의 상태를 재설정할 수 있게 했다. 이후, 구조에 핍홀 연결인 세포에서 게이트로의 연결을 추가했다. 또한, 출력 활성화 기능이 생략되었다. 2009년에는 장단기 메모리 기반 모델이 문서 분석 및 인식 국제 학술회의(ICDAR) 필기 인식 대회에서 우승했다. 그 세 가지 모델은 알렉스 그레이브스 팀의 것이었으며, 하나는 대회에서 가장 정확한 모델이었고 다른 하나는 가장 빠른 모델이다. 장단기 메모리 네트워크는 고전적인 텍사스 인스트러먼트(Texas Instruments)와 매사추세츠 공과대학교(MIT)가 제작한 자연 음성 데이터 베이스(TIMIT)에서 17.7%의 음소 오류율을 달성한 네트워크의 주요 구성요소이다. 2014년, 조경현 등은 게이트 리커런트 유닛(GRU)이라는 단순 변종을 내세웠다. 이후, 구글은 구글 보이스의 음성 인식을 위해 장단기 메모리를 사용하기 시작했으며, 새로운 모델의 오류를 49% 줄였다. 또한, 알로 대화 애플리케이션에서 메시지를 위해 장단기 메모리를 사용하기 시작했다. 구글은 장단기 메모리를 활용해 번역 오류를 60% 줄인 구글 번역용 구글 뉴럴 머신 번역 시스템을 출시했으며, 애플은 월드와이드 개발자 컨퍼런스에서 아이폰의 퀵타입과 시리(Siri)를 위한 장단기 메모리사용을 시작한다고 발표했고, 아마존은 문자 음성 기술에 양방향 장단기 메모리를 이용해 알렉사의 목소리를 내는 폴리(Polly)를 출시했다.

페이스북은 장단기 메모리를 이용하여 매일 45억 개의 자동 번역 작업을 수행했다. 미시간 주립대학교(MSU), IBM 리서치, 코넬대 연구진이 '지식 검색 및 데이터 마이닝(KDD, Knowledge Discovery and Data Mining)' 컨퍼런스에서 널리 사용되는 장단기 메모리의 특정 데이터 집합에서 더 나은 성능을 보이는 새로운 신경 네트워크를 연구 결과를 발표하기도 했다. 2019에 워털루 대학의 연구원들은 연속적인 시간의 창을 나타내는 순환인공신경망 구조와 관련된 제안을 했다. 르장드르(Legendre) 다항식을 사용하였으며, 일부 메모리 관련 벤치마크에서 장단기 메모리을 능가했다. 장단기 메모리 모델은 대형 텍스트 압축 벤치마크에서 3위로 올라섰다.[4]

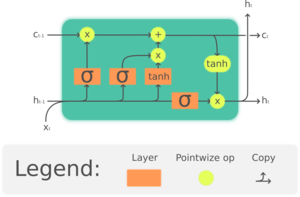

- 순환인공신경망 구조

장단기 메모리는 딥러닝 분야에서 사용되는 순환인공신경망(RNN) 구조이다. 표준 피드포워드 신경망과 달리 장단기 메모리는 피드백 연결이 있다. 단일 데이터 지점과 전체 데이터 시퀀스를 처리할 수 있다. 예를 들면, 장단기 메모리는 분할되지 않은 연결된 필기 인식과 음성 인식 및 네트워크 트래픽이나 내부 감지 시스템(IDS)에서의 이상 감지와 같은 작업에 적용할 수 있다. 공통 장단기 메모리 장치는 셀, 입력 게이트, 출력 게이트 및 기억 게이트로 구성된다. 셀은 임의의 시간 간격에 걸쳐 값을 기억하며, 세 개의 게이트는 셀로 들어오고 나가는 정보의 흐름을 조절한다. 장단기 메모리 네트워크는 시계열 데이터(time series data)의 분류와 처리 및 예측에 적합하다. 시계열에서 중요한 사건 사이에 알 수 없는 지속시간의 시차가 있을 수 있기 때문이다. 장단기 메모리는 기존의 순환인공신경망을 훈련할 때 발생할 수 있는 소실 구배 문제(vanishing gradient problem)를 해결하기 위해 개발되었다. 순환인공신경망과 숨겨진 마르코프 모델 및 기타 시퀀스 학습 방법들에 비해 갭 길이에 대한 상대적 불감증은 장단기 메모리의 장점이다.[4]

이러한 기술적 진보로 인공지능은 다양한 시스템에서 결론을 구축할 수 있게 되었다. 예를 들어, 대량의 텍스트를 기반으로, 말의 뉘앙스에 대해 자력으로 배울 수 있게 된 것이다. 위르겐 슈미트후버는 이런 종류의 인공지능 훈련을 인간의 뇌가 중대한 순간을 골라 장기 기억에 남기고 흔한 사건은 사라짐에 맡기는 것에 비유한다. 중요한 것은 기억하고 중요하지 않은 것은 무시할 수 있게 되었다. 장단기 메모리는 음성인식과 번역인데 화상 캡션 생성도 가능하다. 영상을 보고 그것을 설명하는 말을 써내는 것이다. 이 같은 힘 덕분에 장단기 메모리는 질병 예측부터 작곡까지 다양하게 응용되어 인공지능 분야에서 가장 큰 상업적 성과를 거둘 수 있었다.[1]

신경망 개척자[편집]

2016년 슈미트후퍼는 딥 러닝 및 신경망에 대한 선구적인 공헌으로 전기전자기술자협회(IEEE) 신경망 개척자 상을 수상했다.[5]

런던에서 열린 코그엑스(CogX) 인공지능의 최신 개발과 잠재적 영향에 대한 컨퍼런스에서 샤드볼트 교수는 "로봇이 우리를 밀어내고 로봇 혁명을 일으키는 결정을 하지 않는다는 것이 명확하기 때문에 전혀 위험하지 않으며, 만약 킬러 로봇이 있다면 인간의 결정없이 로봇에게 그렇게 하도록 지침이나 소프트웨어를 제공할만큼 인간이 어리석을 때"라고 전했다. 또한, 인공지능의 도래가 인류의 운명을 바꿀 수 있다는 견해를 내비치며 "오락 산업은 이런 아이디어를 머릿속에 심어놓는 데는 힘이 되지만 실제 현실에서는 이런 플롯이 정말 바보 같은 것"이라고 말했다. 인간 친화적인 인공지능을 만드는 기업의 경우는 강력한 상업적 압박을 받고 있다고도 강조했다. 위르겐 슈미트후버는 "인공지능 연구의 95%는 인간의 삶을 오랫동안 건강하고 더 행복하게 만드는 데에 관한 것이며, 기업들은 사람들이 사고 싶은 걸 팔려고 한다"라고 설명했다.[6]

공로 논란[편집]

슈미트후버는 자신과 다른 연구자들이 딥러닝 분야에서 충분한 인정을 받지 못하고 있으며, 2018년 튜링상(Turing Award)을 수상한 제프리 힌튼(Geoffrey Hinton), 요슈아 벤지오(Yoshua Bengio), 얀 르쿤(Yann LeCun)이 과대평가되었다고 주장했다. 그는 2015년 "통렬한" 글을 작성하여 힌튼, 벤지오, 르쿤이 "서로를 과도하게 인용하면서도" 딥러닝의 선구자들에게 공로를 돌리지 않는다고 비판했다.

뉴욕타임스(New York Times)와의 인터뷰에서 얀 르쿤은 "위르겐(슈미트후버)은 인정을 너무 갈망하며, 자격 없는 공로를 주장하는 경우가 많다... 그는 항상 발표가 끝날 때 일어나서 자신이 했다고 주장하는데, 대부분 정당한 이유 없이 그렇다"고 말했다. 이에 대해 슈미트후버는 르쿤이 "단 하나의 예시도 제시하지 않은 채" 비판했다며 반박했고, 힌튼, 벤지오, 르쿤과의 여러 공로 분쟁 사례를 상세히 공개했다.

AI 커뮤니티에서는 누군가의 연구에 대해 공개적으로 원조를 주장하는 슈미트후버의 습관을 두고 "schmidhubered"라는 표현을 농담 삼아 사용하기도 한다. 일부 연구자들은 그의 대립적인 성향이 그의 중요한 업적이 저평가되는 원인이라고 보고 있다.

평가[편집]

슈미트후버는 2013년 국제 신경망 학회(International Neural Network Society)의 헬름홀츠 상(Helmholtz Award)을 수상했으며, 2016년에는 IEEE 계산 지능 학회(IEEE Computational Intelligence Society)의 신경망 선구자 상(Neural Networks Pioneer Award)을 "딥러닝과 신경망에 대한 선구적인 공헌"으로 수상했다.[51] 그는 유럽 과학 예술 아카데미(European Academy of Sciences and Arts)의 회원이기도 하다.

그는 "현대 AI의 아버지" 또는 이와 유사한 호칭, "생성 AI의 아버지," 그리고 "딥러닝의 아버지"로 불리기도 한다. 그러나 슈미트후버 본인은 알렉세이 그리고리예비치 이바흐넨코(Alexey Grigorevich Ivakhnenko)를 "딥러닝의 아버지"라고 부르며, 더 이전의 AI 선구자들에게도 공로를 돌리고 있다.

견해[편집]

슈미트후버는 오픈 소스 AI의 지지자이며, 오픈 소스 AI가 상업적 폐쇄형 AI와 경쟁력을 갖출 것이라고 믿는다.

1970년대부터 슈미드후버는 "자신의 생애 동안 스스로 학습하고 개선하며 자신보다 똑똑해질 수 있는 지능형 기계"를 만들고자 했다. 그는 AI를 두 가지 유형으로 구분한다: 의료 개선과 같은 도구 AI와, 스스로 목표를 설정하고 연구를 수행하며 우주를 탐험하는 자율 AI. 그는 수십 년 동안 이 두 유형의 AI를 연구해 왔으며,진화의 다음 단계는 인간 문명을 대체할 자기 개선형 AI가 될 것이고, 이 AI는 우주 전체로 확장되어 점점 더 복잡해지는 보편적 증가의 다음 단계를 이끌 것으로 기대한다. 또한 그는 AI가 가시 우주를 식민지화할 것으로 예상한다.

동영상[편집]

각주[편집]

- ↑ 이동: 1.0 1.1 Bloomberg Businessweek, 〈「AIの生みの親」シュミットフーバー、業界が煙たがる男の物語(前編)〉,《newspicks》, 2018-06-16

- 이동 ↑ ソニー株式会社, 〈SXSW 2019出展について〉, 《피알타임즈》, 2019-02-22

- 이동 ↑ Jürgen Schmidhuber Wikipedia - https://en.wikipedia.org/wiki/J%C3%BCrgen_Schmidhuber

- ↑ 이동: 4.0 4.1 Long short-term memory wikipedia - https://en.wikipedia.org/wiki/Long_short-term_memory

- 이동 ↑ 〈Juergen Schmidhuber〉,《pro motivate》

- 이동 ↑ 조인혜, 〈옥스포드대 교수 “인간이 어리석을 때만 킬러 로봇 존재”〉, 《로봇신문》, 2018-06-18

참고자료[편집]

- 위르겐 슈미트후버 홈페이지 - https://people.idsia.ch/~juergen/

- "Jürgen Schmidhuber", Wikipedia

- ソニー株式会社, 〈SXSW 2019出展について〉, 《피알타임즈》, 2019-02-22

- 〈Long short-term memory〉, 《LSTM wikipedia》

- 〈Jürgen Schmidhuber〉, 《Jürgen Schmidhuber wikipedia》

- Bloomberg Businessweek, 〈「AIの生みの親」シュミットフーバー、業界が煙たがる男の物語(前編)〉,《newspicks》, 2018-06-16

- 〈Juergen Schmidhuber〉, 《pro motivate》

- 조인혜, 〈옥스포드대 교수 “인간이 어리석을 때만 킬러 로봇 존재”〉, 《로봇신문》, 2018-06-18

같이 보기[편집]

| ||||||||||||||

위키원

위키원