확률적 경사하강법(Stochastic Gradient Descent, SGD)은 무작위로 배치 크기가 1인 단 한 개의 데이터를 추출하여 기울기를 계산하고, 경사 하강 알고리즘을 적용하는 방법을 말한다. 빠르게 최적점을 찾을 수 있지만 비교적 노이즈가 심하다는 단점이 있다.

개요

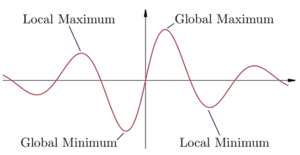

확률적 경사하강법은 머신러닝 알고리즘에 대한 최적의 매개변수 구성을 찾는 방법이다. 네트워크 오류를 줄이기 위해 반복적으로 머신러닝 네트워크 구성에 작은 조정을 한다. 오류 함수가 일반적인 포물선처럼 간단한 경우는 드물다. 대부분 기울기가 심한 언덕과 계곡이 많다. 이 그래프의 왼쪽에서 실제 경사하강법이 시작되면 이 지점에서 어느 방향으로 이동하든 위로 이동해야 하기 때문에 왼쪽 계곡에서 멈춘다. 이 지점을 로컬 최소치라고 한다. 그러나 그래프에는 더 낮은 점이 또 있다. 전체 그래프에서 가장 낮은 지점은 확률적 경사하강법이 찾으려고 하는 전역 최소값이다. 확률적 경사하강법은 각 훈련 지점 후에 네트워크의 구성을 조정하여 전역 최소값을 찾으려고 한다. 이 방법은 전체 데이터 세트에 대해 오류를 줄이거나 기울기를 찾는 대신 무작위로 선택한 배치에 대한 기울기를 근사하게 함으로써 오류를 줄인다. 실제로 무작위 선택은 데이터 세트를 무작위로 섞고 단계적으로 배치를 통해 작업함으로써 달성된다. 만약 네트워크가 훈련 예제를 잘못 받으면 이후에 정확하게 수행하기 위해 구성을 업데이트할 것이다. 그러나 구성 업데이트로 다른 질문을 잘못 받아 네트워크의 전체 오류를 증가시킬 수 있다. 따라서 모든 훈련 반복이 확률적 경사하강 알고리즘을 통해 네트워크를 개선할 수 있는 것은 아니다. 반면에 확률적 경사하강법은 모델을 로컬 최소값에서 전역 최소값으로 이동시키는 방식으로 네트워크 매개변수를 조정할 수 있다. 오목함수를 다시 살펴보면, 훈련 사례를 처리한 후 알고리즘은 우리가 있던 로컬 최소값에서 벗어나기 위해 그래프에서 오른쪽으로 이동하도록 선택할 수 있다. 그렇게 하면 네트워크의 오차가 커지지만, 언덕 위로 이동할 수 있다. 이렇게 하면 추가 훈련을 통해 경사하강법이 전역 최소값으로 이동하도록 할 수 있다. 확률적 경사하강법의 이점은 일반적으로 최소값으로 수렴하면서 실제 경사하강법보다 훨씬 적은 계산이 필요하다는 것이다.[1]

각주

참고자료

같이 보기

|

이 확률적 경사하강법 문서는 인공지능 기술에 관한 글로서 검토가 필요합니다. 위키 문서는 누구든지 자유롭게 편집할 수 있습니다. [편집]을 눌러 문서 내용을 검토·수정해 주세요. 이 확률적 경사하강법 문서는 인공지능 기술에 관한 글로서 검토가 필요합니다. 위키 문서는 누구든지 자유롭게 편집할 수 있습니다. [편집]을 눌러 문서 내용을 검토·수정해 주세요.

|

| 인공지능 : 인공지능 서비스, 인공지능 로봇, 인공지능 기술 □■⊕, 인공지능 기업, 인공지능 인물

|

|

|

| 인공지능 기술

|

AI 워싱 • 랭체인 • 로봇공학 • 로봇기술 • 인지과학 • 자동추론 • 자연어 처리 • 지능 • 지식표현 • 컴퓨터 비전 • 튜링 테스트 • 프롬프트 • 프롬프트 엔지니어링

|

|

|

| 문자인식과 음성인식

|

ICR • OCR • OMR • TTS • URL • 글자 • 답변 • 대화 • 동영상 • 디자인 • 맥락 • 문서 • 문자 • 문자인식 • 문자채팅 • 발음 • 번역 • 분류 • 상담 • 소스코드 • 스토리 • 얼굴 • 얼굴인식 • 음성 • 음성채팅 • 음성인식(STT) • 이미지 • 인공어 • 인공지능 음성 • 자막 • 자연어 • 질문 • 채팅 • 코드 • 코딩 • 텍스트 • 통번역 • 통역 • 파일 • 폴더 • 화상채팅 • 화자인식

|

|

|

| 인공지능 데이터

|

데이터라벨러 • 데이터라벨링 • 데이터셋 • 돌마 • 벡터 • 벡터DB • 벡터공간 • 스칼라 • 임베딩 • 크라우드워커 • 토큰 • 토큰화

|

|

|

| 인공지능 학습

|

ADP • CoLLM • DALL-E • DDPG • DQN • LAM • LMM • SARSA • sLLM • SLM • 강화학습 • 거대언어모델(LLM) • 결정이론적 메타추론 • 계통적 강화학습 • 과적합 • 동적 계획법 • 딥러닝 • 딥큐러닝 • 머신러닝(기계학습) • 메타추론 • 모델 기반 강화학습 • 모델 프리 강화학습 • 미세조정(파인튜닝) • 반영식 아키텍처 • 비지도학습 • 사전학습 • 수시 알고리즘 • 어니 • 에이전트 • 인공지능 학습 • 전이학습 • 준지도학습 • 지도학습 • 추론 • 학습 • 확률적 경사하강법

|

|

|

| 인공지능 알고리즘

|

AGI • ANI • ASI • RAG • XAI • 가중치 • 관계형 네트워크(RN) • 뉴런 • 다층퍼셉트론 • 단층퍼셉트론 • 데이터마이닝 • 방사신경망 • 볼츠만 머신 • 분산 샌드박스 • 생성대립신경망(GAN) • 생성형 AI • 수퍼얼라인먼트 • 순전파 • 순환신경망(RNN) • 시그모이드 함수 • 신경망 • 신경망 구조 • 심층신경망(DNN) • 심층신뢰신경망(DBN) • 양방향 비고정값 암호 체계(TSID) • 역전파 • 은닉층 • 인공신경망(ANN) • 인공지능(AI) • 제한 볼츠만 머신(RBM) • 전방전달신경망 • 주의 메커니즘 • 코헨 자기조직 신경망 • 텍스트마이닝 • 트랜스포머 • 파이 • 퍼셉트론 • 합성곱 신경망(CNN)

|

|

|

| 계산복잡도

|

NP • NP-완전 • 계산복잡도 • 공간복잡도 • 시간복잡도 • 여 NP • 여 NP-완전

|

|

|

| 인공지능 프로그램

|

BCI • GPT • 딥블루 • 딥페이크 • 멀티모달 AI • 모달 • 모달리티 • 모달창 • 알렉스넷 • 어니 • 알파고 • 알파고제로 • 알파폴드 • 왓슨 • 카페 • 컨트롤넷 • 텐서플로 • 텔레파시 • 토치 • 파이토치 • 한돌

|

|

|

| 인공지능 특징

|

결정이론 • 계산상의 합리성 • 논리학 • 논리주의자 • 분산성 • 불확실성 • 삼단논법 • 선호도 • 예측곤란성 • 완벽한 합리성 • 유계 합리성 • 이유 불충분의 원리 • 자율성 • 최대기대효용 • 할루시네이션 • 효용이론

|

|

|

| 인공지능 법적 지위

|

권리주체성 • 소버린 AI • 전자대리인 • 전자적 인간 • 책임법

|

|

|

| 위키 : 자동차, 교통, 지역, 지도, 산업, 기업, 단체, 업무, 생활, 쇼핑, 블록체인, 암호화폐, 인공지능, 개발, 인물, 행사, 일반

|

|

위키원

위키원