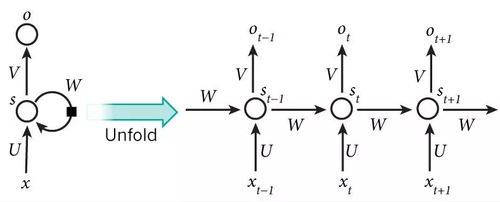

순환신경망(RNN, Recurrent Neural Network)는 유닛간의 연결이 순환적 구조를 갖는 인공신경망의 한 종류이다. 알엔엔(RNN)이라고 읽는다.

순환신경망은 시퀀스 데이터를 모델링 하기 위해 등장했다. 순환 신경망이 기존의 뉴럴 네트워크와 다른 점은 '기억'을 갖고 있다는 점인데, 네트워크의 기억은 지금까지의 입력 데이터를 요약한 정보라고 볼 수 있다. 새로운 입력이 들어올때마다 네트워크는 자신의 기억을 조금씩 수정한다. 결국 입력을 모두 처리하고 난 후 네트워크에게 남겨진 기억은 시퀀스 전체를 요약하는 정보가 된다. 이는 사람이 시퀀스를 처리하는 방식과 비슷하다. 이 글을 읽을 때도 우리는 이전까지의 단어에 대한 기억을 바탕으로 새로운 단어를 이해한다. 이 과정은 새로운 단어마다 계속해서 반복되기 때문에 순환 신경망에는 Recurrent, 즉 순환적이라는 이름이 붙는다. 순환신경망은 이런 반복을 통해 아무리 긴 시퀀스라도 처리할 수 있는 것이다.[1]

언어 모델링과 텍스트 생성[편집]

언어 모델은 주어진 문장에서 이전 단어들을 보고 다음 단어가 나올 확률을 계산해주는 모델이다. 언어 모델은 어떤 문장이 실제로 존재할 확률이 얼마나 되는지 계산해주기 때문에, 자동 번역의 출력값으로 어떤 문장을 내보내는 것이 더 좋은지 알려줄 수 있다. 문장에서 다음 단어가 나타날 확률을 계산해주는 주 목적 외의 부수적인 효과로 생성 모델을 얻을 수 있는데, 출력 확률 분포에서 샘플링을 통해 문장의 다음 단어가 무엇이 되면 좋을지 정한다면 기존에 없던 새로운 문장을 생성할 수 있고, 또한 학습 데이터에 따라 다양하고 재밌는 여러 가지를 만들어낼 수도 있다.언어 모델에서의 입력값은 단어들의 시퀀스이고, 출력은 추측된 단어들의 시퀀스이다.[2]

기계 번역[편집]

기계 번역 문제는 입력이 단어들의 시퀀스라는 점에서 언어 모델링과 비슷하지만, 출력값이 다른 언어로 되어있는 단어들의 시퀀스라는 점에서 차이가 있다. 네트워크 상에서 중요한 차이점은, 입력값을 전부 다 받아들인 다음에서야 네트워크가 출력값을 내보낸다는 점에 있는데, 번역 문제에서는 어순이 다른 문제 등이 있기 때문에 대상 언어의 문장의 첫 단어를 알기 위해선 번역할 문장 전체를 봐야 할 수도 있기 때문이다.[2]

음성 인식[편집]

사운드 웨이브의 음향 신호를 입력으로 받아들이고, 출력으로는 음소들의 시퀀스와 각각의 음소별 확률 분포를 추측할 수 있다.[2]

이미지 캡션 생성[편집]

컴퓨터 비전에서 활발하게 사용된 합성곱 신경망(CNN, Convolutional Neural Network)과 순환신경망을 함께 사용한다면, 임의의 이미지를 텍스트로 설명해주는 시스템을 만드는 것이 가능해진다. 합성곱 신경망과 순환신경망을 합친 모델은 이미지로부터 얻어낸 주요 단어들과 이미지의 각 부분을 매칭해줄 수도 있다.[2]

참고자료[편집]

같이 보기[편집]

|

이 순환신경망 문서는 인공지능 기술에 관한 토막글입니다. 위키 문서는 누구든지 자유롭게 편집할 수 있습니다. [편집]을 눌러 이 문서의 내용을 채워주세요. 이 순환신경망 문서는 인공지능 기술에 관한 토막글입니다. 위키 문서는 누구든지 자유롭게 편집할 수 있습니다. [편집]을 눌러 이 문서의 내용을 채워주세요.

|

| 인공지능 : 인공지능 서비스, 인공지능 기술 □■⊕, 인공지능 로봇, 인공지능 기업, 인공지능 인물

|

|

|

| 인공지능 기술

|

AI 워싱 • 랭체인 • 로봇공학 • 로봇기술 • 인지과학 • 자동추론 • 자연어 처리 • 지능 • 지식표현 • 컴퓨터 비전 • 킬 스위치 • 튜링 테스트 • 프롬프트 • 프롬프트 엔지니어링

|

|

|

| 문자인식과 음성인식

|

ICR • OCR • OMR • URL • 감정 • 글자 • 단어 • 답변 • 대화 • 동영상 • 디자인 • 맥락 • 문단 • 문서 • 문자 • 문자인식 • 문자채팅 • 문장 • 발음 • 번역 • 분류 • 상담 • 소스코드 • 스토리 • 얼굴 • 얼굴인식 • 음성 • 음성채팅 • 음성인식(STT) • 음성합성(TTS) • 의미 • 이미지 • 인공어 • 인공지능 음성 • 자막 • 자연어 • 질문 • 채팅 • 출처 • 코드 • 코딩 • 텍스트 • 통번역 • 통역 • 파일 • 폴더 • 화상채팅 • 화자인식

|

|

|

| 인공지능 데이터

|

노드 • 데이터라벨러 • 데이터라벨링 • 데이터셋 • 돌마 • 레이블 • 벡터 • 벡터DB • 벡터공간 • 스칼라 • 시뮬레이션 • 엣지 • 임베딩 • 청크(Chunk) • 크라우드워커 • 토큰 • 토큰화

|

|

|

| 인공지능 학습

|

ADP • CoLLM • DALL-E • DDPG • DQN • LAM • LMM • SARSA • sLLM • SLM • 강화학습 • 거대언어모델(LLM) • 결정이론적 메타추론 • 계통적 강화학습 • 과적합 • 기억 • 단기기억 • 동적 계획법 • 딥러닝 • 딥큐러닝 • 머신러닝(기계학습) • 메타추론 • 모델 기반 강화학습 • 모델 프리 강화학습 • 미세조정(파인튜닝) • 반영식 아키텍처 • 비지도학습 • 사전학습 • 수시 알고리즘 • 어니 • 에이전트 • 인공지능 학습 • 자기지도학습 • 장기기억 • 전이학습 • 준지도학습 • 지도학습 • 추론 • 학습 • 훈련

|

|

|

| 인공지능 알고리즘

|

AGI • ANI • ASI • FFN • MHSA • RAG • ReLU 함수 • Seq2Seq • XAI • Word2Vec • 가중치 • 경사하강법 • 관계형 네트워크(RN) • 기울기 소실 • 뉴런 • 다층퍼셉트론 • 단층퍼셉트론 • 데이터마이닝 • 디코더 • 로지스틱 함수 • 리키 ReLU 함수 • 매개변수 • 미시 함수 • 방사신경망 • 볼츠만 머신 • 분산 샌드박스 • 비선형 함수 • 생성대립신경망(GAN) • 생성형 AI • 선형 함수 • 소프트맥스 함수 • 손실함수 • 수퍼얼라인먼트 • 순전파 • 순환신경망(RNN) • 스위시 함수 • 시그모이드 함수 • 신경망 • 신경망 구조 • 심층신경망(DNN) • 심층신뢰신경망(DBN) • 양방향 비고정값 암호 체계(TSID) • 어탠션 • 에이전트체인(CoA) • 역전파 • 역치 • 온도 • 원핫 • 은닉층 • 인공신경망(ANN) • 인공지능(AI) • 인코더 • 입력층 • 잔차신경망(레즈넷) • 제한 볼츠만 머신(RBM) • 전방전달신경망(FFNN) • 정렬위장 • 주의 메커니즘 • 초매개변수(하이퍼 파라미터) • 출력층 • 코헨 자기조직 신경망 • 탄젠트 함수 • 텍스트마이닝 • 트랜스포머 • 파이 • 퍼셉트론 • 하이퍼볼릭 탄젠트 함수(tanh) • 학습률 • 합성곱 신경망(CNN) • 확률분포 • 확률적 경사하강법 • 활성화 함수

|

|

|

| 계산복잡도

|

NP • NP-완전 • 계산복잡도 • 공간복잡도 • 시간복잡도 • 여 NP • 여 NP-완전

|

|

|

| 인공지능 프로그램

|

BCI • GPT • 딥블루 • 딥페이크 • 멀티모달 AI • 모달 • 모달리티 • 모달창 • 어니 • 알파고 • 알파고제로 • 알파폴드 • 왓슨 • 카페 • 컨트롤넷 • 텐서플로 • 텔레파시 • 토치 • 파이토치 • 한돌

|

|

|

| 인공지능 장비

|

GPU • 그래픽카드 • 레니게이드 • 반도체 • 엔비디아 • 엔비디아 A100 • 엔비디아 H100 • 엔비디아 H200 • 집적회로(칩)

|

|

|

| 인공지능 특징

|

결정이론 • 계산상의 합리성 • 논리학 • 논리주의자 • 분산성 • 불확실성 • 삼단논법 • 선호도 • 예측곤란성 • 완벽한 합리성 • 유계 합리성 • 이유 불충분의 원리 • 자율성 • 최대기대효용 • 할루시네이션 • 효용이론

|

|

|

| 인공지능 법적 지위

|

권리주체성 • 소버린 AI • 전자대리인 • 전자적 인간 • 책임법

|

|

|

| 위키 : 인공지능, 개발, 자동차, 교통, 지역, 지도, 산업, 기업, 단체, 업무, 생활, 쇼핑, 블록체인, 암호화폐, 인물, 행사, 일반

|

|

위키원

위키원